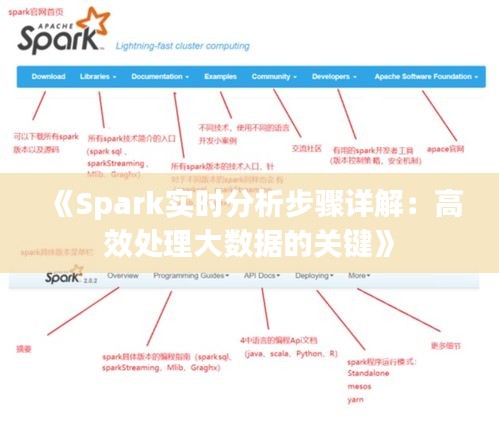

标题:《Spark实时分析步骤详解:高效处理大数据的关键》

随着大数据时代的到来,实时分析成为企业决策的重要依据。Spark作为一种高效的大数据处理框架,在实时分析领域具有广泛的应用。本文将详细介绍Spark实时分析的步骤,帮助读者更好地理解和应用Spark进行实时数据分析。

一、Spark实时分析概述

Spark实时分析是指利用Spark框架对实时数据流进行处理和分析,从而实现对数据的实时监控、预警和决策支持。Spark实时分析具有以下特点:

-

高效性:Spark采用内存计算和分布式计算,能够快速处理海量数据。

-

可扩展性:Spark支持弹性计算,可以根据需求动态调整资源。

-

易用性:Spark提供了丰富的API和工具,方便用户进行开发。

-

生态丰富:Spark与其他大数据技术(如Hadoop、Hive、Spark SQL等)具有良好的兼容性。

二、Spark实时分析步骤

- 数据采集

数据采集是Spark实时分析的第一步,主要涉及以下内容:

(1)确定数据源:根据业务需求,选择合适的数据源,如日志文件、数据库、消息队列等。

(2)数据接入:使用Spark Streaming或其他实时数据处理工具,将数据源中的数据实时接入Spark。

(3)数据预处理:对采集到的数据进行清洗、去重、格式化等预处理操作,确保数据质量。

- 数据存储

数据存储是Spark实时分析的基础,主要涉及以下内容:

(1)选择存储系统:根据数据量和查询需求,选择合适的存储系统,如HDFS、Cassandra、Redis等。

(2)数据写入:将处理后的数据写入存储系统,以便后续查询和分析。

- 数据处理

数据处理是Spark实时分析的核心,主要涉及以下内容:

(1)定义Spark程序:使用Spark API定义数据处理逻辑,包括数据转换、过滤、聚合等操作。

(2)运行Spark程序:将Spark程序提交到Spark集群中运行,对数据进行实时处理。

(3)优化Spark程序:根据实际运行情况,对Spark程序进行优化,提高处理效率。

- 数据分析

数据分析是Spark实时分析的目的,主要涉及以下内容:

(1)数据可视化:将处理后的数据通过图表、报表等形式进行可视化展示。

(2)数据挖掘:利用机器学习、数据挖掘等技术,从数据中发现有价值的信息。

(3)决策支持:根据分析结果,为企业决策提供支持。

- 数据监控与报警

数据监控与报警是Spark实时分析的重要保障,主要涉及以下内容:

(1)实时监控:对Spark集群和应用程序进行实时监控,确保系统稳定运行。

(2)报警机制:当系统出现异常时,及时发出报警,以便快速定位和解决问题。

三、总结

Spark实时分析在数据处理、分析、可视化等方面具有显著优势,已成为大数据领域的重要技术。通过本文对Spark实时分析步骤的详细介绍,相信读者能够更好地理解和应用Spark进行实时数据分析。在实际应用中,根据业务需求和数据特点,灵活调整Spark实时分析步骤,以提高数据分析的效率和准确性。

转载请注明来自北京凯建昌盛工程技术有限公司,本文标题:《《Spark实时分析步骤详解:高效处理大数据的关键》》

京ICP备19050683号-2

京ICP备19050683号-2